Nell’anno 2007 quando ho iniziato ad esplorare la SEO ho avuto da subito un approccio molto personale, quello di affidarmi al mio intuito ed alla mia esperienza di progettista software provando ad immaginare cosa avrei fatto io se avessi voluto realizzare un motore di ricerca come Google.

Ovviamente le idee c’erano ma a metterle sotto forma di algoritmo avrebbe richiesto l’intervento di qualcuno molto più preparato di me in materia, fortunatamente non era nelle mie intenzioni scrivere un motore di ricerca ma provare a mettermi “nei suoi panni” per capire quale fosse il modo migliore per “compiacerlo” e fargli scegliere le mie pagine come risultati di ricerca.

SEO Semantica, le mie origini

A quei tempi già era nota la frase di Bill Gates “Content is King” diventata il motto SEO per eccellenza e dal quale sono partite tante delle mie riflessioni come la domanda ovvia: “Come si può capire, dal punto di vista algoritmico, se un content è veramente king?”

Informandomi in giro non trovavo altro che riferimenti ad un unico parametro, la keyword density, detto in parole povere rappresenta la percentuale di documento occupato dalla parola chiave. Ovviamente più volte era presente la parola chiave più saliva la percentuale.

Volete sapere la mia esclamazione dinanzi a queste letture? Ma si ve la dico in piena sincerità (e volgarità) : “Ma che cacata!!!”

Ebbene si non potevo accettare che Google fosse così fesso, non si diventa il primo motore di ricerca al mondo con cavolate del genere.

Approfondendo gli studi mi sono reso subito conto del divario incredibile che c’era tra gli esperti stranieri e quelli italiani, qualcosa di veramente vergognoso. In Italia non si diceva altro che tenere la keyword density intorno al 3% massimo 4%, senza mai dire per quale stramaledetto motivo dovesse essere così, mentre all’estero si parlava di algoritmo LSI (Latent Semantic Indexing) comunque molto vicino al concetto di keyword density e di algoritmi semantici basati sulle ricerche di IBM per l’archiviazione e catalogazione di libri in biblioteche informatizzate (information retrieval).

La mia reazione è stata quella di indagare nell’unico modo in cui credo, quello numerico, realizzando software di analisi dei testi.

Sfida SEO N.1 : Sfatare il mito della keyword density

Il primo passo è stato quello di realizzare un semplice software che partendo da una keyword navigasse i 10 siti web della prima pagina di Google e calcolasse la loro keyword density per la parola chiave specifica.

Il risultato del test su centinaia di parole chiave è stato esattamente quello che mi aspettavo, per ogni parola chiave di ricerca le keyword density erano completamente diverse, si oscillava dall’ 1% ad addirittura 20% su parole chiave dove tutti facevano keyword stuffing.

Sfatato il mito del 3% , ogni settore ed ogni parola chiave aveva il suo range di KD diverso ma sopratutto ogni parola chiave presentava documenti di dimensioni completamente diverse, a volte mi sono trovato dinanzi a veri e propri libri monopagina.

Sfida SEO N.2 : Capire cosa avessero in comune i siti top

Se era chiaro che la keyword density non fosse determinante non ero comunque arrivato ad una risposta soddisfacente per le mie domande. Queli erano allora i fattori comuni dei siti web scelti da Google nelle SERP? Avevo veramente bisogno di analizzare più a fondo i documenti scelti da Google, dovevo individuare i tasselli mancanti.

Mi metto nuovamente all’opera e modifico il software che avevo realizzato per studiare le keyword density e scrivo un algortimo basato su LSI (fatto in casa con i suoi limiti) per individuare tutte le parole ricorrenti in tutti i documenti e le rispettive keyword density. Ordino i dati per KD e/o per occorrenze e riesco ad avere un’idea più chiara.

I siti migliori non venivano scelti in base ad una sola keyword density ma ad una “ricetta” di termini utilizzati in KD bilanciate in tal modo da creare un Topic univoco. In pratica Google riusciva a capire l’argomento del documento pesando le occorrenze di termini specifici. Era fondamentale che la “ricetta” fosse bilanciata perfettamente altrimenti Google poteva fraintendere e credere che si stesse parlando di tutt’altro argomento.

L’insieme di parole rilevanti di un documento lo battezzai “Wordspace”, mi piaceva molto il termine. Un concetto fondamentale che capii subito era che argomenti diversi potevano condividere esattamente lo stesso Wordspace esattamente come due ricette possono condividere gli stessi ingredienti ma essere completamente diverse.

Provo a farvi un esempio di Wordspace che crea ambiguità:

- Auto

- Gomme

- Curve

- Bagnato

- Guida

Con questo Wordspace sono perfettamente identificabili i seguenti Topic

- Un articolo che parli del rendimento di pneumatici

- Formula 1

- Una sezione di un documento di scuola guida

- Con un po di fantasia ne trovate altri…

Utilizzando questo Wordspace (ingredienti) in quantità diverse si riesce a determinare il taglio del documento. Se si parla maggiormente di gomme e bagnato probabilmente stiamo parlando di pneumatici invernali.

LDA (Latent Dirichlet Allocation)

Ricercando sul web informazioni che potessero validare la mia ricerca mi imbattei in vari acronimi come LSA (Latent Semantic Analisys) e LDA e mi resi conto che ero sulla buona strada per scrivere un software di copywriting in grado di aiutarmi a competere sempre per i primi posti su Google e di avere la chiave per creare il tanto ambito King Content.

Non voglio entrare troppo nel dettagli di cosa facciano gli algoritmi LDA ed LSA, in primis perchè non sono un matematico e sopratutto perchè se pure lo fossi credo che non interesserebbe a nessuno. La cosa importante da dire su LDA dal punto di vista pratico per i SEO è che l’algoritmo individua vari Topic all’interno di un documento e l’insieme dei topic (argomenti) rende più o meno rilevante il documento per una o più determinate parole chiave.

Se riuscirete ad individuare i Topic che rappresentano correttamente una keyword di ricerca ed il peso da dare ad ogni Topic allora sarete sulla buona strada per scrivere un documento in grado di posizionarsi per la keyword specifica.

Qui vi mostro un video del mio software personale realizzato qualche anno fa : Tool Semantico

Quanto piace LDA a Google?

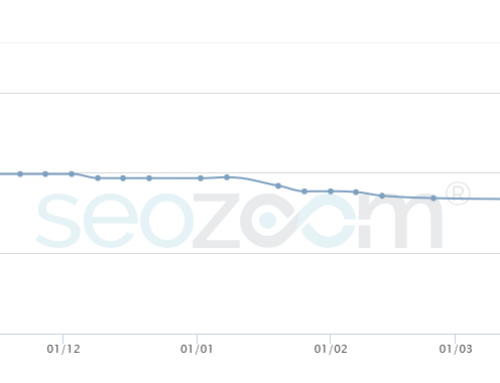

Gli piace tanto e funziona alla grande dal 2010 circa, anno in cui ho iniziato ad utilizzare i miei tool semantici ma da circa 6 mesi ho notato un grande cambiamento algoritmico, da prima di Hummingbird, in pratica ho notato che Google stia dando molta importanza a contenuti ricchi, lunghi a prescindere dalla reale qualità del testo. Una pagina ricca con molti punti (topic di approfondimento) stile Wikipedia è nettamente avvantaggiata rispetto a contenuti, magari più specifici e di qualità ma più concisi.

La conclusione è che sempre più spesso sul web, a fronte di una ricerca, i siti meglio posizionati vi presenteranno una pagina lunghissima paragonabile a circa 15 pagine web “normali” e che girino continuamente intorno all’argomento per rafforzare il topic principale.

Esistono Tool Semantici per scrivere SEO?

Al momento non c’è nulla di specifico, io uso il mio perchè me lo sono fatto su misura per come vedo l’argomento ma vi consiglio di fare un giro su http://www.freebase.com/ per individuare le relazioni tra le varie Entities, è utile per individuare i Topic di cui parlare nei vostri testi.

Nel 2014 spero di riuscire a portare a termine il nostro software SEO, si chiama SEO Zoom, farà veramente tutto quello di cui avrete bisogno.